Знаменитые стеки для обработки

Знаменитые стеки для обработки

Эта статья представляет собой исчерпывающий обзор популярных знаменитых стеков для обработки данных, анализируя их сильные и слабые стороны, а также подходящие сценарии использования. Мы рассмотрим ключевые технологии, популярные среди разработчиков, и предоставим практические примеры их применения. Вы узнаете, как выбрать оптимальный стек для ваших конкретных задач, учитывая масштабируемость, производительность и удобство использования.

Выбор стека: критерии и факторы

Выбор идеального стека для обработки зависит от множества факторов, включая масштаб проекта, тип данных, необходимые функции и опыт команды. Важно учитывать следующие аспекты:

Масштабируемость

Будет ли ваш проект расти? Выбранный стек должен легко адаптироваться к увеличению объема данных и нагрузки. Например, облачные решения, такие как AWS или Google Cloud Platform, предлагают отличную масштабируемость, позволяя быстро увеличивать или уменьшать ресурсы по мере необходимости. При выборе необходимо учитывать возможности горизонтального и вертикального масштабирования.

Производительность

Скорость обработки данных – критический фактор. Некоторые стеки оптимизированы для высокой производительности, в то время как другие могут быть более медленными, но проще в использовании. Например, для задач, требующих высокой скорости обработки больших объемов данных, часто выбирают стеки, основанные на языках программирования, таких как C++ или Go.

Удобство использования

Некоторые стеки более дружелюбны к разработчикам, особенно к тем, кто только начинает работать с обработкой данных. Например, Python с его обширными библиотеками (Pandas, NumPy, Scikit-learn) часто считается более простым в освоении, чем, скажем, Java или C++.

Популярные стеки для обработки данных

Рассмотрим несколько популярных знаменитых стеков для обработки:

Стек на основе Python

Python – один из самых популярных языков для обработки данных благодаря обширной экосистеме библиотек, таких как Pandas (для работы с данными), NumPy (для вычислений), Scikit-learn (для машинного обучения) и Matplotlib/Seaborn (для визуализации). Этот стек подходит для широкого круга задач, от анализа данных до разработки моделей машинного обучения. Его простота и обширная документация делают его отличным выбором для начинающих.

Стек на основе Java

Java – мощный язык, известный своей надежностью и производительностью. Он часто используется в больших корпоративных системах для обработки данных. Библиотеки, такие как Apache Spark и Hadoop, обеспечивают эффективную обработку больших объемов данных. Java-стек подходит для задач, требующих высокой производительности и масштабируемости.

Стек на основе R

R – специализированный язык программирования для статистического анализа и визуализации данных. Он обладает обширными возможностями для статистического моделирования и графического представления результатов. R-стек является идеальным выбором для статистиков и исследователей данных.

Стек на основе Scala

Scala, работающий на JVM, сочетает функциональное и объектно-ориентированное программирование. Он отлично интегрируется с Apache Spark, обеспечивая высокую производительность и масштабируемость для обработки больших данных. Scala-стек популярен в больших распределённых системах.

Выбор стека: практические рекомендации

Выбор знаменитого стека для обработки – это индивидуальный процесс, зависящий от ваших конкретных потребностей. Перед принятием решения, оцените:

- Объём данных

- Сложность задач

- Опыт вашей команды

- Бюджет

- Необходимость масштабируемости

Не бойтесь экспериментировать и тестировать различные стеки, чтобы найти наиболее подходящий для вашего проекта. Помните, что нет одного идеального решения для всех задач.

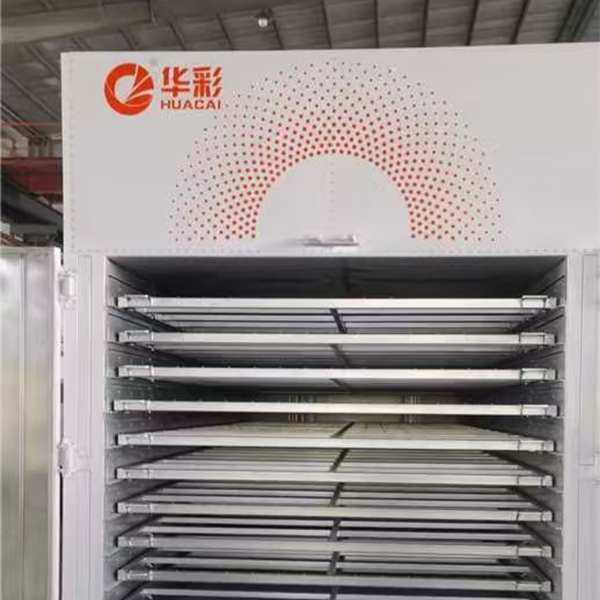

Обратите внимание, что компания ООО Дунгуань Хуацай Интеллектуальные Технологии (https://www.huacai-glass.ru/) специализируется на оборудовании для глубокой переработки стекла, и, хотя это не напрямую связано с программными стеками обработки данных, качественная обработка данных может быть критически важна для оптимизации производственных процессов на предприятиях, подобных этому.

| Стек | Сильные стороны | Слабые стороны |

|---|---|---|

| Python | Простота, обширная экосистема библиотек | Может быть медленнее, чем другие языки для некоторых задач |

| Java | Высокая производительность, масштабируемость | Более сложен в освоении |

| R | Специализированный для статистического анализа | Менее универсален, чем Python или Java |

| Scala | Высокая производительность, интеграция с Spark | Кривая обучения может быть крутой |

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Совершенно новая индивидуальная модель

Совершенно новая индивидуальная модель -

Автоматический вакуумный подъемник с присосками

Автоматический вакуумный подъемник с присосками -

PVB пленка

PVB пленка -

Серии для смешивания и подачи в бак

Серии для смешивания и подачи в бак -

Стандартный нагревательный роликовый пресс

Стандартный нагревательный роликовый пресс -

Гомогенизатор

Гомогенизатор -

Однолинейный вакуумный подъемник для стекла

Однолинейный вакуумный подъемник для стекла -

Нагревательный валковый пресс с принудительной воздушной конвекцией

Нагревательный валковый пресс с принудительной воздушной конвекцией -

Линия для производства плоского ламинированного стекла

Линия для производства плоского ламинированного стекла -

Осушитель

Осушитель -

Платформа для погрузки и разгрузки

Платформа для погрузки и разгрузки -

Компрессор

Компрессор

Связанный поиск

Связанный поиск- машина для производства стекла

- Ведущий покупатель линейных шлифовальных станков для обработки кромки стекла

- Линии для производства листового стекла в Китае

- Ведущий производитель машин для закалки стекла

- обработка стекла

- Превосходная резка и обработка стекла

- Высококачественные печи для полимеризации стекла

- Знаменитая термообработка стекла

- Ведущая линия по производству листового стекла

- Автоклавы для ламинирования стекла Китай